| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | ||||||

| 2 | 3 | 4 | 5 | 6 | 7 | 8 |

| 9 | 10 | 11 | 12 | 13 | 14 | 15 |

| 16 | 17 | 18 | 19 | 20 | 21 | 22 |

| 23 | 24 | 25 | 26 | 27 | 28 |

- 스위치

- 리눅스

- Switch

- function call

- Generalized forward

- 신경망

- Network layer

- 모두를 위한 딥러닝

- Router

- 텐서플로우

- 운영체제

- 인터럽트

- LED 제어

- LED

- Transport layer

- 3분 딥러닝

- 신경망 첫걸음

- GPIO

- 디바이스 드라이버

- demultiplexing

- Interrupt

- Class Activation Map

- file descriptors

- TensorFlow

- 딥러닝

- RDT

- 펌웨어

- Linux

- 밑바닥부터 시작하는 딥러닝

- 모두를 위한 딥러닝]

- Today

- Total

목록공부 기록/인공지능 (12)

건조젤리의 저장소

CNN의 관심영역을 확인해보자 (CAM)

CNN의 관심영역을 확인해보자 (CAM)

CNN을 해석하기 위해서는 어떻게 해야할까? 기본적인 CNN구조에서는 Convolution Layer를 이용하여 특징을 뽑아낸 후 Fully-Connected Layer(FC)를 통과시켜 class의 분류를 수행한다. FC를 통과시키기 위해 Convolution을 이용해 뽑은 특징점의 Flatten과정을 거치게 되고 위치 정보들이 소실된다. 만약 이러한 위치 정보들이 소실되지 않고 유지되며 class분류를 수행할 수 있다면, CNN이 각 class를 분류하는데 중요한 위치정보를 알 수 있지 않을까? Learning Deep Features for Discriminative Localization 논문에서는 특징점의 Flatten과정 대신 각 채널별로 Global Average Pooling(GAP)을 적..

Tensorflow 에서 데이터 Batch처리 손쉽게 구현하기

Tensorflow 에서 데이터 Batch처리 손쉽게 구현하기

더보기 코드 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 x_input = tf.placeholder(tf.float32, [None, 28*28]) y_input = tf.placeholder(tf.float32, [None, 10]) input_dataset = tf.data.Dataset.from_tensor_slices((x_input, y_input)).repeat().batch(100) train_iterator = input_dataset.make_initializable_iterator() next_batch_train = train_iterator.get_next() sess = tf.Session() sess.run(train_iterator.initialize..

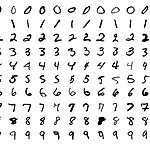

MNIST 예제의 정확도가 너무 낮게 나온다면? (정규화의 중요성)

MNIST 예제의 정확도가 너무 낮게 나온다면? (정규화의 중요성)

다들 MNIST Dataset 을 이용하여 딥러닝 모델을 테스트 한 적이 있을 것입니다. 아무리 단순한 모델이더라도 정확도는 약 80%이상이 나오게 되는데요, 정확도가 20% 이하가 나오게 되면 무슨 문제일까요? 정확도가 낮게 나오는 이유는 여러가지가 있겠지만, 대표적인 문제 중 하나는 입력 데이터의 정규화를 거치지 않으면 생기는 문제입니다. tensorflow 1.x 하위 버전에서는 tensorflow.examples.tutorials.mnist.input_data 라는 모듈이 존재하여, mnist 이미지를 손쉽게 불러올 수 있었고, 각 픽셀값이 0과 1사이로 정규화가 되어 있습니다. 하지만 상위 버전에서는 tf.keras.datasets.mnist.load_data() 모듈을 사용해야 합니다. 불러온..

[ML] 코세라 머신러닝 강의 팁

[ML] 코세라 머신러닝 강의 팁

더보기 목록 한글자막 정리 노트 1. 한글 자막 코세라 머신러닝 강의를 듣다보면 한글 자막이 없는 영상이 대부분이다. 이때 아래 블로그의 방법을 이용하면 한글 자막을 이용할 수 있다. http://blog.naver.com/PostView.nhn?blogId=chandong83&logNo=220792584753&parentCategoryNo=&categoryNo=36&viewDate=&isShowPopularPosts=false&from=postView 코세라 AI 강의 한글 자막 넣어서 보는 방법! 인공지능 스터디를 하다 보면 추천 강의 동영상 중 거의 바이블화된 강의가 있다. 그것은 스텐포드 대학의 ... blog.naver.com 2. 정리 노트 코세라 강의를 보고 이해가 가지 않는 부분은 인터넷 ..

[ML] Backpropagation의 이해

[ML] Backpropagation의 이해

더보기 신경망의 역전파 과정에 대해 더 잘 이해하기 위한 자료들이다. 코세라 강의에서 이해가 가지 않았던 내용이지만, 이 자료들로 어느 정도 이해를 할 수 있었다. https://www.popit.kr/coursera-machine-learning%EC%9C%BC%EB%A1%9C-%EA%B8%B0%EA%B3%84%ED%95%99%EC%8A%B5-%EB%B0%B0%EC%9A%B0%EA%B8%B0-week5/ Coursera Machine Learning으로 기계학습 배우기 : week5 | Popit 개요 지난 시간에 이어 Coursera Machine Learning으로 기계학습 배우기 : week5 정리를 진행한다. 목차 해당 포스팅은 연재글로써 지난 연재는 아래의 링크를 참고한다. Coursera M..

[ML] Normal Equation의 증명

[ML] Normal Equation의 증명

더보기 코세라 강좌 중 Andrew Ng 교수님의 Machine Learning 강좌에서 언급되었던 Normal Equation에 대해 알아보자. Normal Equation은 경사 하강법으로 가중치를 구할때와는 다르게 반복없이 가중치를 구할 수 있는 방법이다. 강좌에서 나온 식은 밑의 식과 같다. 강좌에서는 이 식을 증명하는 과정이 빠져 있는데, 다음의 블로그에서 증명하는 법을 찾을 수 있었다. 링크1: https://eli.thegreenplace.net/2014/derivation-of-the-normal-equation-for-linear-regression/ 링크2: https://kgwcredit.tistory.com/13

케라스로 구현하는 RNN

케라스로 구현하는 RNN

더보기 Rnn keras from Park Seong Hyeon 3분 딥러닝 케라스맛 책 중 RNN 파트만 따로 정리한 내용입니다.

[골빈해커의 3분 딥러닝 텐서플로맛] 정리

[골빈해커의 3분 딥러닝 텐서플로맛] 정리

기본 개념 1234import tensorflow as tf hello = tf.constant('Hello, TensorFlow!')print(hello)cs 출력 Tensor("Const:0", shape=(), dtype=string) 문자열이 아닌 변수의 자료형과 무엇을 담고 있는지 정보가 출력된다. 12345a = tf.constant(10)b = tf.constant(32)c = tf.add(a,b) print(c)cs 출력Tensor("Add:0", shape=(), dtype=int32) 12345678910sess = tf.Session() print(sess.run(hello))print(sess.run([a, b, c])) # b 의미 : byte 코드이다. decode 하면 없어짐 ..