| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

Tags

- 스위치

- 밑바닥부터 시작하는 딥러닝

- LED 제어

- 신경망 첫걸음

- 모두를 위한 딥러닝]

- demultiplexing

- Transport layer

- 인터럽트

- Interrupt

- 텐서플로우

- Linux

- 3분 딥러닝

- 신경망

- 디바이스 드라이버

- Generalized forward

- Router

- GPIO

- RDT

- 펌웨어

- file descriptors

- 딥러닝

- 운영체제

- Network layer

- function call

- Switch

- TensorFlow

- Class Activation Map

- 리눅스

- LED

- 모두를 위한 딥러닝

Archives

- Today

- Total

건조젤리의 저장소

5-1. Windy Frozen Lake (Non-deterministic world) 본문

김성훈 교수님의 강의내용을 정리한 내용입니다.

출처 : http://hunkim.github.io/ml/

모두를 위한 머신러닝/딥러닝 강의

hunkim.github.io

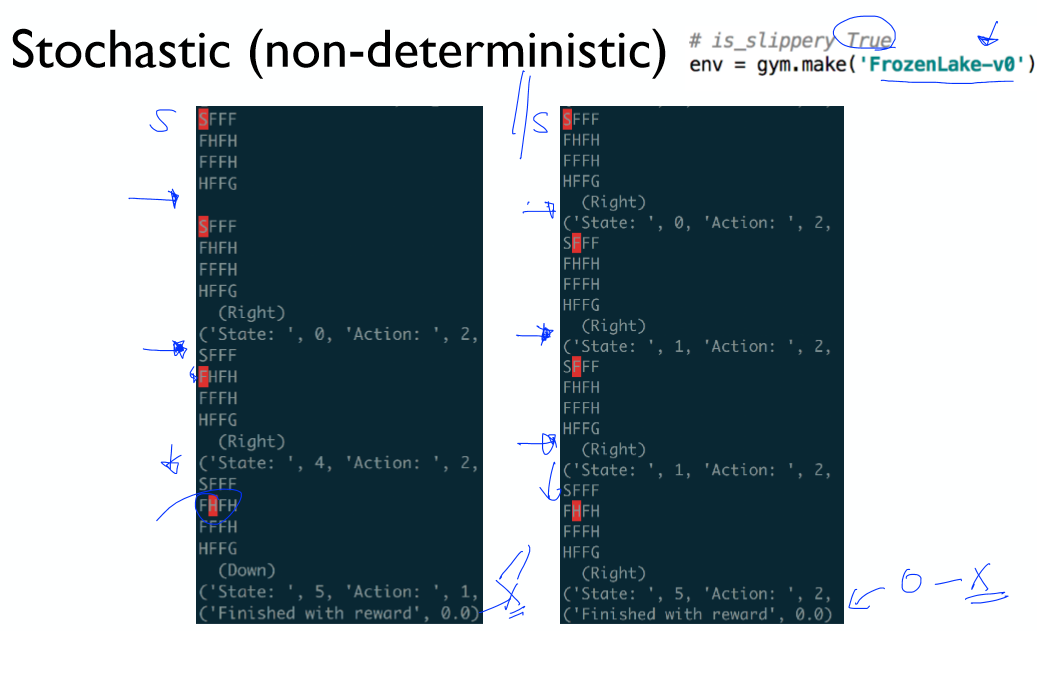

이전의 Fronzen Lake는 평화로웠지만 Windy Frozen Lake는 바람이 많이 부는 위험한 지역이다.

내가 원하는 방향으로 이동하고자 해도 바람이 세기 때문에 미끄러질수 있다!

Windy Frozen Lake와 같은 환경은 Stochastic(nondeterministic) 이라 한다.(일정하지 않음)

내가 원하는 방향으로 잘 이동한다!

내가 원하는 방향으로 잘 가지않고 바람이 세기 때문에 미끄러진다!!!

(v0 버전은 is_slippery 옵션이 켜져있다.)

기존의 Q-learning이 효율적이지 못하다!

Q가 오른쪽으로 이동해 보상을 받았다고 말해준다고 해도,

Q는 실제로 오른쪽으로 이동하지 않았을 수 있다! (미끄러져서 우연히 보상을 받음)

이를 해결하기 위한 해결책은 Q의 말을 조금만 반영하는 것이다. (learning rate을 설정하는 것처럼)

Q를 업데이트 할 때 Learning rate를 이용하여 비율을 조정하여 업데이트 한다!

수식을 정리하여 위와 같이 나타낼 수 있다.

이 공식을 적용했을 때의 Q 근사치 또한 Q에 수렴한다는 사실이 증명되었다고 한다.

'공부 기록 > 모두를 위한 딥러닝 (RL)' 카테고리의 다른 글

| 6-1. Q-Network (0) | 2019.11.19 |

|---|---|

| 5-2. Windy Frozen Lake 구현 (0) | 2019.11.19 |

| 4-2. Q-learning 구현 (table) (0) | 2019.11.19 |

| 4-1. Q-learning (0) | 2019.11.19 |

| 3-2. Dummy Q-learning 구현 (0) | 2019.11.18 |

Comments