| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- Linux

- 스위치

- Generalized forward

- 모두를 위한 딥러닝

- Transport layer

- 3분 딥러닝

- file descriptors

- LED 제어

- Switch

- RDT

- demultiplexing

- Network layer

- 모두를 위한 딥러닝]

- function call

- 운영체제

- 펌웨어

- 딥러닝

- 신경망

- 밑바닥부터 시작하는 딥러닝

- 신경망 첫걸음

- 디바이스 드라이버

- 리눅스

- 인터럽트

- Router

- TensorFlow

- LED

- Class Activation Map

- Interrupt

- GPIO

- 텐서플로우

Archives

- Today

- Total

건조젤리의 저장소

12-5. Dynamic RNN 본문

김성훈 교수님의 강의내용을 정리한 내용입니다.

출처 : http://hunkim.github.io/ml/

모두를 위한 머신러닝/딥러닝 강의

hunkim.github.io

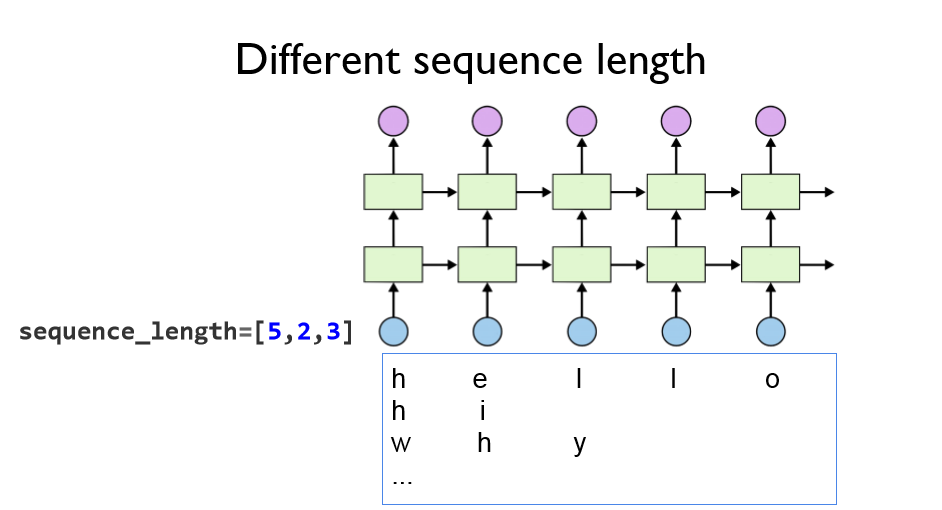

고정 길이의 데이터가 아닌 가변 길이의 데이터를 넣기 위한 기존 방법은

빈 자리에 Pad라는 특별한 기호를 사용하여 신경망이 이 부분은 없는 것으로 스스로 판단하길 유도하였다.

하지만 이 자리에도 가중치값이 존재하기 때문에 Loss 함수를 최적화 하기 어렵게 만들었다.

이를 해결하기 위해 Tensorflow는 각각 배치에 sequence길이를 입력하게 하여 출력값도 이와 동일한 길이를 출력하게 하였다. (나머지 부분은 0으로 만든다)

sequence길이에 따라 출력되는 결과를 살펴보면,

설정한 길이 외의 결과값은 모두 0이 된 것을 볼 수 있다.

'공부 기록 > 모두를 위한 딥러닝 (Basic)' 카테고리의 다른 글

| 12-6. RNN with time series data (stock) (0) | 2019.11.14 |

|---|---|

| 12-4. Tensorflow를 이용한 RNN + Softmax layer 구현 (0) | 2019.11.13 |

| 12-3. Tensorflow를 이용한 RNN 예제 실습 (0) | 2019.11.13 |

| 12-2. Tensorflow를 이용한 RNN 기초 실습 (0) | 2019.11.13 |

| 12-1. RNN (0) | 2019.11.13 |

Comments